Наукометрический подход к измерению «продукта» исследований приобрел большую популярность среди менеджеров и администраторов многих стран. Главным объектом наукометрических определений стала система научных коммуникаций, прежде всего массивы публикаций и уровень цитируемости авторов разных стран. Считается, что число публикаций отражает количество производимой научной продукции, а цитируемость этих публикаций — качество продукции.

Оба этих тезиса в общем случае неверны, и на основании таких измерений делать выводы нельзя. Научная публикация — это лишь «упаковка» научной продукции, вернее, один из многих видов упаковки. Можно ли сравнивать хотя бы количество продукции, не говоря уже о его качестве, сравнивая число упаковок, не исследуя содержимое?

Важен и тот факт, что большая часть научно-технической информации передается не через формальные каналы (публикации), а через непосредственное личное общение и частную или полуформальную переписку. Эти каналы наукометрия не учитывает.

Что же касается цитируемости статей как меры научного вклада их авторов, то в качестве общего показателя оценки цитируемость использоваться не может (изучение библиографических ссылок с успехом применяется в науковедческих исследованиях для других целей).

Если бы работы всех авторов в одинаковой степени доводились до сведения мировой научной общественности (предположение заведомо неправильное), то высокая цитируемость какого-либо автора действительно указывала бы на то, что его вклад в науку высок.

Но низкая цитируемость автора не позволяет сделать вывода, что его научный вклад невелик.

Это становится ясно из рассмотрения «элементарного акта» цитирования. Автор, ссылаясь на другие работы, действует по принципу «все — или ничего», он или включает какую-то статью в библиографию, или не включает. Он оценивает ту работу, ссылку на которую помещает в библиографию своей статьи, в 1 балл, а все остальные работы, которые использовал в своем исследовании, но не может процитировать, — в 0 баллов. Но ценность тех работ, которые он использовал, вовсе не отличается так скачкообразно — или 0, или 1. И выходит, что работа с ценностью 0,99 балла все равно оценивается как бесполезная, она получает 0 баллов.

В среднем библиография статьи содержит около 10 ссылок — это лишь небольшая доля тех работ, результатами которых пользовался автор в своем исследовании (примем, что он действительно использовал самые ценные для его исследования работы).

Предположим, автор использовал информацию из 100 работ, и по их реальной ценности они могут быть ранжированы, получив оценки от 1 до 100 баллов. В библиографию попадают работы, набравшие более 90 баллов, от 91 до 100. Они, разумеется, наиболее полезны для исследования автора. Однако работа с реальной ценностью в 90 баллов оценивается через цитирование в 0 баллов, как и работа с реальной ценностью в 1 балл. Дело не меняется оттого, что эта ситуация воспроизводится много раз и в целом возникает сравнительно плавное распределение работ по их цитируемости.

Это создает правдоподобие оценки, не придавая ей достоверности.

На основании такого параметра ничего нельзя сказать о ценности таких работ — они оказываются в зоне неопределенности. А если еще есть дополнительные факторы, которые снижают цитируемость какой-то совокупности авторов, как это и есть в отношении российских публикаций, то использование этого параметра в качестве показателя приводит к заведомо ложным оценкам. Причем ошибка будет исключительно грубой. На деле это просто фальсификация, подлог.

Обсуждая возможность измерения цитирования для оценки «выхода» научной продукции, мы приняли ряд идеализирующих ситуацию предположений. На деле много факторов приводят к тому, что низкая цитируемость ценных работ даже внутри сообщества западных ученых – не редкость. Обсуждение всех этих факторов не входит в нашу задачу, и мы просто приведем два примера.

В 1979 году С. Вейнберг был удостоен Нобелевской премии за теоретическую работу, изложенную в статье, опубликованной в 1967 году. Вот число ссылок на эту статью по годам:

Мы видим, что в течение 5 лет (немалый срок) эта работа практически не цитировалась, и в это время будущий нобелевский лауреат, попадись он энтузиасту формализованных оценок продуктивности, мог бы быть не аттестован для продолжения научной работы. Почему же последовал затем такой бурный рост цитируемости? Объяснение заключается в том, что в 1971 году голландский математик Г. Хофт опубликовал работу, которая позволила упростить математическую трактовку теории С. Вейнберга.

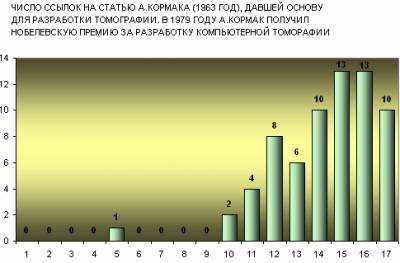

Не менее наглядна динамика цитирования главной статьи нобелевского лауреата по физиологии и медицине А. Кормака, разработавшего математический анализ поглощения рентгеновских лучей тканями. Эта работа (1963 год) была необходима для создания сканирующего рентгеновского томографа. Вот цитируемость этой работы:

Потенциальная ценность работы Кормака проявилась лишь тогда, когда была создана необходимая для томографии ЭВМ (для разработки которой эта статья создала математическую базу).

Оба эти случая являются прекрасными свидетельствами того, что открытия и изобретения следует рассматривать как системы, необходимые элементы которых порой создаются подспудно. Сам же факт открытия — это создание элемента или связи, недостающих для достраивания целостной системы, это — момент рождения системы, всегда очень заметный.

Ничто так не вредит применению количественных методов, как игнорирование того факта, что существуют неформализуемые аспекты и величины, которые нельзя выразить в численной мере.

Научный потенциал, как и продуктивность (страны, учреждения, исследователя), — это многоаспектная характеристика, которая не может быть выражена численно и принимает весьма различные значения в зависимости от контекста. Как бы ни была велика потребность в простом и надежном методе оценки научного потенциала, необходимо реалистично подходить к нашим возможностям. Непредвзятое выяснение их ограниченности само по себе очень важно для лучшего понимания проблемы. Параметр цитируемости публикаций российских авторов никаким показателем быть не может, и его наукообразность и правдоподобность никак не могут извинить верхоглядства тех, кто пытается сделать из этих измерений какие-то многозначительные выводы.

Когда в конце 60-х годов ХХ века на Западе началась волна разработки и применения формализованных количественных методов оценки сложных видов деятельности, вопрос о методологической обоснованности этих подходов какое-то время был в центре внимание ученых и философов.

Лауреат Нобелевской премии О.Н. Хиншельвуд писал: «В настоящее время существует опасность, что может возникнуть серьезная путаница в том, каким образом общество, находящееся под влиянием силы научного метода, но имеющее мало интуитивного чувства практики настоящего ученого, сможет установить критерии меры и количества для качественных вещей, к которым они неприложимы. Если количественные измерения действительно приложимы – очень хорошо. Однако все еще имеется искушение там, где это не может быть сделано, произвольно заменять хорошие, но субъективные критерии явно худшими только потому, что эти последние могут быть представлены в данных числовых измерений и рассматриваемы механически.

Стремление поступать подобным образом еще более возросло в связи с модой вводить информацию в вычислительные машины. В самом деле, если вы введете в машину разумное, то и получите разумный результат. Однако, к несчастью, если вы введете неразумное, то получите не имеющее смысла решение, которое будет еще менее разумным, так как не будет сразу распознано в качестве чепухи, каковой оно в действительности является.

Защитой ложного количественного подхода не будет также и то, что мы часто не знаем лучшего выбора. Если не известно, каким путем достичь правильного суждения, то лучше уж принять факт как таковой и не делать положение хуже, чем оно есть, путем симуляции. Я считаю, что замена трудных качественных суждений неадекватными механическими данными не является рационализацией или эффективностью или же беспристрастностью и объективностью, а просто представляют собой весьма печальное отсутствие ответственности» [Хиншельвуд О.Н. Качественное и количественное. — В кн. «Философские проблемы современной химии», М.: «Прогресс». 1971, с. 21-32].

Именно это «весьма печальное отсутствие ответственности» наблюдается в том, как Минобрнауки РФ применяет количественные параметры в качестве индикаторов для оценки труда ученых и преподавателей вузов. http://www.rusrand.ru/mission/kolonka-kara-murzi/kolonka-kara-murzi_66.html

|